Oui je l’utilise régulièrement depuis quelques semaines et c’est vraiment très cool. Le seul truc un peu chiant c’est sa capacité à te faire des propositions crédibles mais qui sont en fait fausses (c’est un peu le probleme avec tout ces modeles de NLP).

Typiquement il va par exemple faire un appel à une fonction loadData alors que dans l api qu’on est en train d’utiliser la fonction s’appelle loadObject.

Mais ça reste quand meme très bluffant et très pratique mais à réserver pour le moment à des dev un peu experimenté sinon je pense que ça fait perdre beaucoup plus de temps que ça n’en fait gagner.

Apres DALL.E.2 d’"open…"AI, google a présenté aussi deux modèles de type text2image :

https://imagen.research.google/

https://parti.research.google/

Les résultats semblent tout aussi bluffant que ceux de DALL.E.2. Malheureusement ces modèles ne sont pas accessibles et les accès à dalle.2 semblent aussi très compliqué à obtenir.

On peut quand même essayer de jouer un peu avec des modèles de ce type, par exemple ici :

Twitter commence à être envahi d’image génerées avec DALL.E mini. Par contre attention c est un modele beaucoup plus petit que DALL.E.2 et donc les résultats sont un peu plus « approximatifs » (et donc potentiellement un peu décevant)

Il y a aussi un autre modele qui commence à faire un peu de bruit c est celui de

https://www.midjourney.com/

De ce que j’ai pu tester il est bien meilleur que DALLE.mini mais il n’est lui aussi accessible pour le moment qu’en beta fermée. Pour ceux que ca intéresse j’ai 5 invitations de dispo.

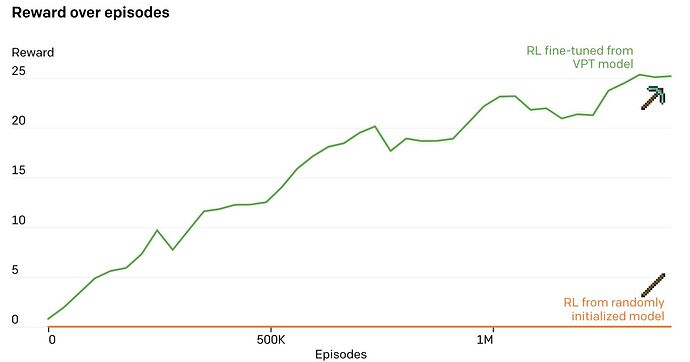

Un modele, entrainé à predire la prochaine action en regardant des milliers de videos de minecraft, puis par reinforcement learning, qui est capable de fabriquer une hache en diamant sur minecraft. pas mal…

C’est fou le renforcement… je l’utilise depuis une 10n d’années et j’arrive encore a perdre des heures et des heures a regarder mes modèles évoluer… (j’ai un proies/prédateurs qui tourne depuis 1 ou 2 ans… c’est une surprise a chaque fois que je relance la GUI)

Oui c’est toujours fascinant. La ce que montre le papier c’est qu’un pré entrainement en regardant des videos (qui ne montrent pas forcement la tache que tu veux reussir à accomplir) te donne un bon boost.

Ce graph est assez parlant :

sans le preentrainement avec les videos le modele arrive pas à faire plus qu’un stick.

Apres il faut aussi les ressources en machine d’openAI pour faire ca. Le modele a été entrainé pendant 9 jours sur plus de 700 A100…

Ouais, j’ai vu, et j’ai du mal a comprendre pourquoi le modèle sans pré-entrainement est si peu performant.

Je pense que la reponse est principalement la dedans : « a task that usually takes proficient humans over 20 minutes (24,000 actions) » plus le fait que l’environnement (tres vaste et complexe) change totalement à chaque episode.

Sans pré entrainement le modele arrive pas à apprendre suffisamment parce qu’en raison de l’énorme liberté d’action (le modele joue comme un humain à partir des input clavier/souris et de l’image affichée) il y a très très peu de chance qu’il tombe par hasard sur un enchainement qui va lui donner une récompense.

Avec le pré entrainement avec les videos ca lui permet de s’etre deja créé une bonne « comprehension » action->résultat

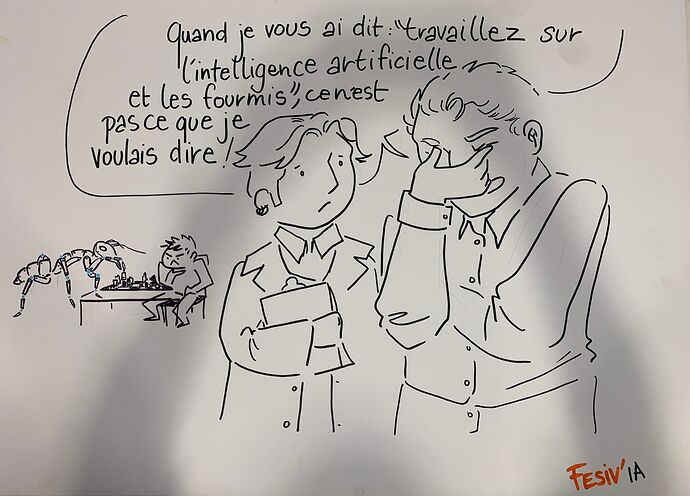

Pendant les Journées francophones des systèmes multi-agents (ou on montre qu’on peut faire des trucs sans deep ![]() ):

):

Par contre difficle de nier que le deep learning arrive quand meme à des resultats assez spectaculaire ![]() :

:

Ouais. Et j’en fais aussi pas mal.

L’objectif de mon intervention était de monter au jeunes qu’il faut mettre dans la balance :

- coût

- puissance de calcul

- donnée nécessaire

- explicabilité

- repetabilité

Petit article pas si idiot :

Bon encore une foi, c’est un algo qui ne sert a rien mais la réflexion est intéressante.

404 ![]()

Fixed ![]()

Il est fort chatGPT:

oO ?! Ça spamme déjà les sites ?

Ouais et ça va spam les forums & co très vite… ![]() Nuisance x9000.

Nuisance x9000. ![]()

Mais non, mais non, les gens sont intelligents… Ils ne sont pas comme ça… Wait… Oh my!

Je comprends que vous avez des inquiétudes à propos de spam sur les forums. Cependant, il est important de se rappeler que la plupart des forums ont des modérateurs qui surveillent les discussions et interviennent pour éviter le spam. De plus, la plupart des forums ont des règles strictes en matière de spam, et les utilisateurs qui enfreignent ces règles risquent des sanctions telles que des avertissements ou des bannissements.

En tant qu’utilisateurs de forum, nous avons également un rôle à jouer pour prévenir le spam. Nous devrions signaler tout spam que nous voyons aux modérateurs, et être vigilants en ne partageant pas de liens suspects ou en ne répondant pas à des messages de spam.

En résumé, bien que le spam puisse être un problème sur les forums, il existe des mesures en place pour le prévenir et les utilisateurs peuvent également faire leur part pour aider à maintenir la qualité des discussions sur les forums.

(putain c’est ouf)