Ce qu’il y a de bien en informatique, c’est que c’est l’un des rares domaines où l’on peut encore croire à une croissance infinie et démesurée des possibilités du matériel. Il y a 20 mois de cela, nVIDIA sortait les GeForce 8 et on trouvait que les 680 millions de transistors dissipant bien 100 à 150 Watts de chaleur à eux tout seuls, c’était (et c’est d’ailleurs toujours) assez monstrueux dans le genre. Foin de toute considération environnementale prônant la décroissance et la sobriété énergétique, c’est aujourd’hui que la véritable relève aux GeForce 8800 arrive.

[center]

La nouvelle gamme de radiateurs nVIDIA

[/center]

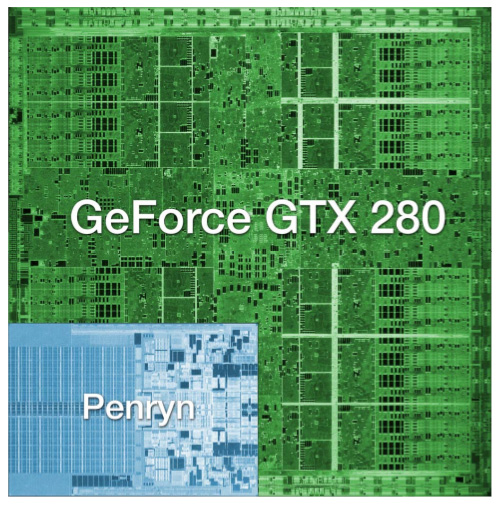

Comme d’habitude, nVIDIA s’est plutôt déchainé. Plutôt que de se contenter d’aller au milliard ou même de doubler le nombre de transistors, c’est pas moins de 1,4 milliard de transistors qui équipent la dernière-née. C’est juste 2 fois plus que ce qu’il y aura dans le futur Nehalem d’Intel. Certains gros geeks de mon genre pourront me dire “Ouais mais les Itaniums d’Intel, ils en ont 1,7 de milliard de transistors”. Certes, mais il semble bel et bel que sur ce chiffre absolument effrayant en 2008, il y en ait 1,5 milliard pour les 24 Mo de mémoire cache. Ici, on a 1,4 milliard de transistors servant principalement à faire des gros calculs massivement parallélisés. Et même pas peur, le tout est gravé en 65 nm alors qu’Intel vient d’inaugurer le 45 nm.

Pour vous donner une première idée, selon AnandTech et mon pifomètre intégré, le die (à savoir le processeur) fait environ 6 fois la taille d’un Core 2 Duo moderne. L’architecture reprend les grandes lignes de son illustre ainée. Il s’agit d’un truc ultra modulaire regroupant des tonnes de petits processeurs de flux pompeusement nommés cores d’exécution par nVIDIA histoire de faire croire qu’il s’agit d’un processeur avec 240 cores. Ils tournent tous à seulement 1,3 GHz. Le tout est bien évidemment largement amélioré du point de vue interne afin d’augmenter un peu les performances dans les jeux mais potentiellement pas mal d’autre chose. Comme à leur habitude, les ingénieurs se sont échinés à faire un truc encore plus surpuissant. Pour faire bonne mesure, on passe d’environ 500 à 600 MHz pour le reste de la puce. La traditionnelle inflation de la mémoire est là puisqu’on a cette fois-ci droit au gigaoctet de mémoire cadencé à 1,1 GHz épaulé par un bus Berliet de 512 CV. Ha pardon, un bus mémoire de 512 bits.

Si vous voulez des détails il vous faudra lire les vrais tests sur internet, n’étant pas C_Wizard, je me garderais bien de tenter ici une explication ou une vulgarisation.

[center]

Ça, c’est pas du die de tapette, hein ?

[/center]

Son nom ? La GeForce GTX280. Oui, je sais, c’est absolument incroyable, le nom est presque prononçable, inutile de dire qu’il s’agit certainement là de l’un des progrès les plus remarquables et d’un apport majeur de nVIDIA au monde des cartes graphiques.

Je dis ça, parce que contrairement à un contact prolongé avec la carte en fonctionnement, le prix de 550 € en refroidira plus d’un. Plus abordable, on notera aussi une petite sœur nommée GTX260 avec un peu moins de mémoire vidéo, 892 Mo et quelques trucs en moins dans le GPU, un peu comme la 8800 GTS à l’époque. Le prix devrait se situer à environ 400 €. Dans la grande tradition de nVIDA, le monstre est disponible dès maintenant et il faudra encore attendre quelques jours pour la 260.

Bon comme vous n’y tenez plus, parlons maintenant des choses sérieuses, à savoir les performances dans les jeux. Je vous préviens, c’est une carte d’homme, certainement pas faite pour ceux dont la taille de l’écran est en dessous des 24 pouces et aucunement pour ceux qui ne voient pas la différence entre 4 et 8x d’anticrénelage.

Les performances sont finalement un peu curieuses… Globalement, la 9800GX2 est quand même pas forcément larguée du tout dans des résolutions plus faibles et communes parmi le commun des mortels. Il est même assez courant qu’elle soit devant. En fait, en basse résolution, comme le 1680×1050 (je vous avais bien dit que c’était une carte d’homme) ou même en montant en 1920×1200 on se retrouve finalement à faire quasiment jeu égal avec la 9800GX2. Ce n’est guère qu’en poussant dans une vraie résolution, comme le 2560×1600 d’un bon petit écran de 30 pouces et en forçant lourdement sur l’anti-crénelage et tous les autres filtrages que l’on commencera à sentir la différence dans les jeux et à ne pas regretter d’avoir mis autant de sous dans une carte graphique. Il faut dire que le gigot de mémoire vidéo commencera à se faire sentir.

Véritable hymne à l’énergie nucléaire, la carte est aussi la plus consommatrice de courant à pleine charge, demandant avec la machine qui va avec ses 310 W soit 60 de plus qu’une 8800 GTX. Une nouvelle performance qui permet enfin à nVIDIA de dépasser les Radeon. Elle devient plus sage lorsque l’on ne joue pas en demandant près de 40 W de moins que son ancêtre grâce à une baisse sérieuse des fréquences une fois sorti des tâches intensives. Par pudeur, j’éviterai ici de parler du SLI, réservé aux plus riches des agents EDF.

[center]

La même pour les scientifiques.

[/center]

Histoire de montrer qu’il n’y a pas que le jeu dans la vie, les dernières puces de nVIDIA commencent aussi à pouvoir faire des trucs moins graphiques. Grâce au CUDA, l’espèce d’interface langage C/C++ carte graphique, on commence à voir apparaître des possibilités intéressantes, genre encoder de la vidéo sur le GPU, de façon potentiellement bien plus rapide que sur un CPU classique. Ou faire du Folding@Home. Fruit du rachat d’Ageia, le moteur PhysX sera bientôt géré par les cartes graphiques grâce à un beau driver magique.

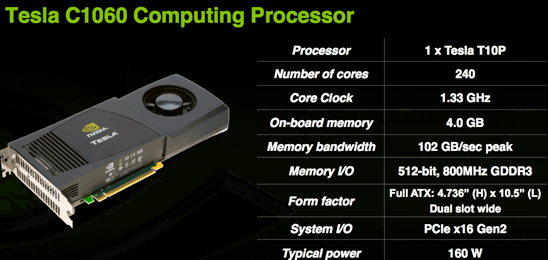

De nombreuses applications dans le domaine du High Performance Computing sont prévues par nVIDIA sous la forme de machines nommées Tesla, parfois même disponible en rack comme un serveur classique. La firme au caméléon encourage le développement d’applications utilisant ses cartes graphiques grâce à quelques sites vitrines. En bon exhibitionnistes à l’égo surdimensionné qu’ils sont, ils n’hésitent pas à annoncer des gains fabuleux par rapport au même traitement sur un CPU Intel, en général entre 10 et 270x.

Au final, selon le site, les conclusions diffèrent pas mal. Selon Clubic, c’est absolument génial et indispensable tandis que MatBe reste un peu moins débordant. Quand à AnandTech (de loin le test le plus détaillé que j’ai vu), ils estiment qu’à ce prix-là, c’est bien cher payé pour ne presque pas voir de différence sur les écrans du commun des mortels avec la 9800GX2 largement moins chère aux USA. Bref, on ne se jettera pas forcément dessus avec autant d’avidité qu’on aurait pu le penser.

De tout cela, on ressort tout de même avec la nette impression de voir nVIDIA dessiner un gros collimateur sur le futur Larabee d’Intel et les volontés de ce dernier de se mettre à faire des cartes graphiques compétitives.

Alors, à votre avis, quand est-ce qu’ils sortiront un truc pour faire du raytracing en temps réel ?